如何用python進行中文分詞

東西/原料

- python 3.8.2(其他版本也可以)

- pycharm 2020.01(其他版本也可以)

方式/步調

- 1

在本次教程中,我們采用pycharm進行編程。起首領會一下jieba庫,jieba庫是優異的中文分詞第三方庫。

jeiba庫分詞的道理:jieba分詞依靠中文詞庫,操縱一個中文詞庫,確定中文字符之間的聯系關系概率,中文字符間概率大的構成詞組,形當作分詞成果。

- 2

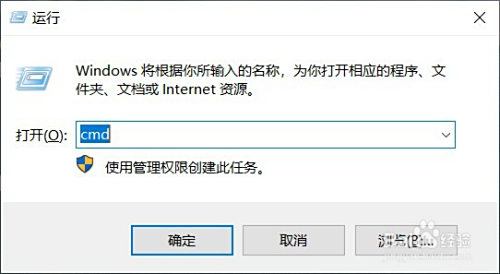

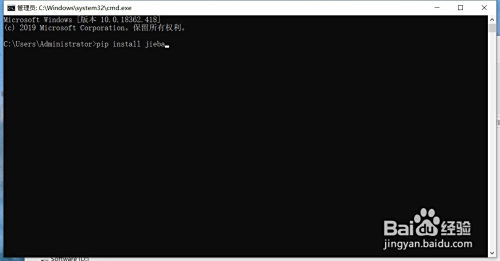

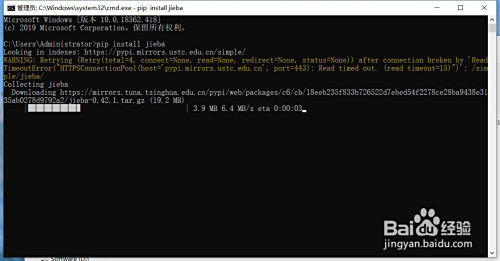

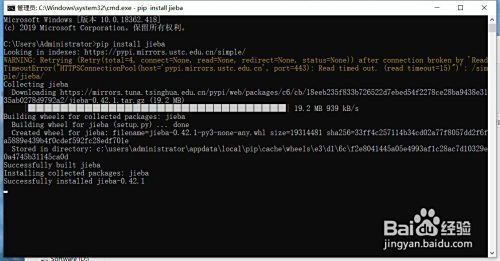

安裝jieba庫:

在桌面摁下“win”+“r”,輸入cmd,接著輸入“pip install jieba”,期待號令交運行完當作,當呈現“successful”就申明jieba庫已經安裝當作功了。

- 3

jieba庫有三種分詞模式,切確模式、全模式、搜刮引擎模式。

切確模式:把文本切確地且分隔,不存在冗余單詞。

全模式:把文本中所有可能的詞語都掃描出來,詞與詞之間存在反復部門,有冗余。

搜刮引擎模式:在切確模式根本上,對長詞再次切分。

- 4

jieba庫常用函數:

1、jieba.lcut(s) 切確模式,返回一個列表類型的分詞成果

2、jieba.lcut(s, cut_all=True) 全模式,返回一個列表類型的分詞成果,有冗余

3、jeiba.lcut_for_search(s) 搜刮引擎模式,返回一個列表類型的分詞成果,存在冗余

(其他函數操作可以參照官方文檔)

- 5

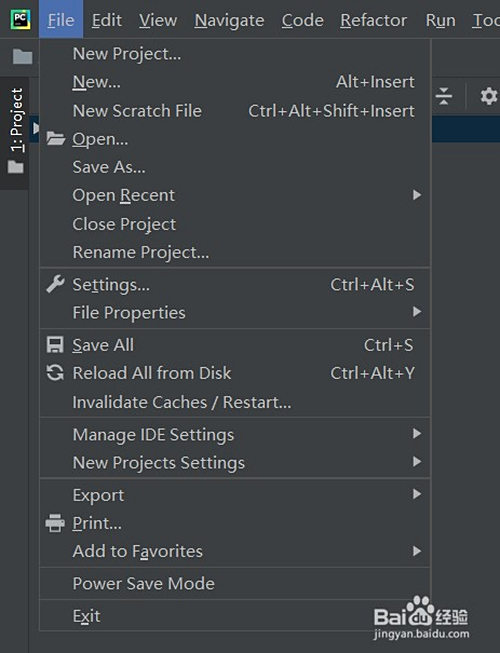

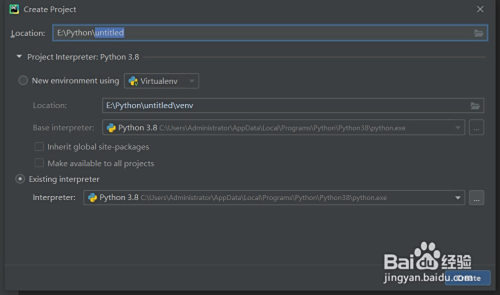

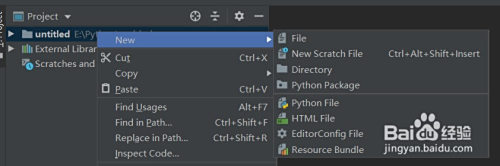

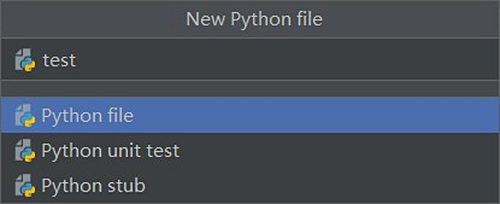

打開pycharm,點擊左上角“File”-“New Project”新建一個項目(圖1),選擇肆意目次,選擇python 3.8詮釋器,點擊“cerate”,在project處右鍵點擊“New”-“Python File”,肆意取一個名字回車

- 6

在新建的py文件中輸入:

import jieba

txt = "把文本切確地分隔,不存在冗余單詞"

# 切確模式

words_lcut = jieba.lcut(txt)

print(words_lcut)

# 全模式

words_lcut_all = jieba.lcut(txt, cut_all=True)

print(words_lcut_all)

# 搜刮引擎模式

words_lcut_search = jieba.lcut_for_search(txt)

print(words_lcut_search)代碼即可實現對字符串txt的分詞

END

注重事項

- 文章利用pycharm進行編程,也可以利用IDLE進行編程。

- jieba庫在安裝時,若頻仍呈現timeout,可以過段時候再試,或者運行 pip install jieba -i https://pypi.tuna.tsinghua.edu.cn/simple/ 利用清華源進行安裝

- 官網文檔請在pypi搜刮jieba

- 發表于 2020-04-24 19:00

- 閱讀 ( 2372 )

- 分類:其他類型

你可能感興趣的文章

- DNF維京硬幣如何獲取與兌換 1100 瀏覽

- 龍族幻想午夜頻道攻略 1074 瀏覽

- 御劍修仙游戲如何添加好友 1069 瀏覽

- 明日之后,如何快速完成制作烤肉任務 1173 瀏覽

- 御劍修仙如何在地圖里找到如歌 1192 瀏覽

- 最強大腦急轉彎111 1193 瀏覽

- 劍與遠征哭嚎荒漠通關攻略視頻 1381 瀏覽

- 如何做前空翻(初學者) 2513 瀏覽

- 200斤胖子如何減身上的贅肉 1591 瀏覽

- 跑步的時候怎么改善自己呼吸節奏的技巧 1429 瀏覽

- 怎么在運動過程中保持持續的體力 1277 瀏覽

- 火車票正晚點怎么查詢,智行火車票查詢正晚點 2022 瀏覽

- 戶外自行車騎行需要準備哪些裝備 1496 瀏覽

- 智行火車票怎么查看足跡 6355 瀏覽

- 腦洞大師《逃離密室》11、12、13關怎么過攻略 1657 瀏覽

- 智行火車票12306搶票怎么添加收件地址 1542 瀏覽

- 抖音定格畫面視頻怎么弄 4023 瀏覽

- 智行火車票12306搶票怎么添加常用旅客 1927 瀏覽

- 腦洞大師《逃離密室》8/910關怎么過攻略 2130 瀏覽

- 蘇州美食攻略之小吃篇 1514 瀏覽

- 單點解怎么變成固定解 5134 瀏覽

- 何為蘇州園林,蘇州園林包含哪些主要園林 1622 瀏覽

- 蘇州博物館之基本陳列篇 1874 瀏覽

- 江浙酒店攻略 1398 瀏覽

- 小雞第一個月怎么養 1816 瀏覽

- java爬蟲系列:怎么用jsoup進行爬蟲開發?(3) 1405 瀏覽

- 百度文庫知識店鋪開通流程 1999 瀏覽

- iOS 13在哪里開啟三維觸控 2934 瀏覽

- 蘋果手機怎么修改短信鈴聲 1688 瀏覽

- 教你使用數據可視化軟件創建房產運營可視化大屏 1343 瀏覽

相關問題

0 條評論

0 篇文章

作家榜 ?

-

xiaonan123

189 文章

xiaonan123

189 文章

-

湯依妹兒

97 文章

湯依妹兒

97 文章

-

luogf229

46 文章

luogf229

46 文章

-

jy02406749

45 文章

jy02406749

45 文章

-

小凡

34 文章

小凡

34 文章

-

Daisy萌

32 文章

Daisy萌

32 文章

-

我的QQ3117863681

24 文章

我的QQ3117863681

24 文章

-

華志健

23 文章

華志健

23 文章

推薦文章

- 腦洞大師《逃離密室》5/6/7關攻略

- 如何在車里舒服的睡覺

- 藍車圖片設計

- 彩鳳蝶圖片設計

- 城稻城亞丁自助游攻略

- 燭碗圖片設計

- 怎么在支付寶中參與行走公益捐步

- 腹肌鍛煉方法

- 杜鵑紅山茶花注意事項

- 如何正確練習踢毽子

- 夢幻誅仙如何增強仙侶戰斗力

- 2k20手機版徽章怎么解鎖

- CSGO卡光效技巧

- 陰陽師怎么改綁定的身份證

- 孤島驚魂5找出葛蕾絲阿姆斯壯的儲藏室

- 明日之后,如何提升驍勇善戰等級到3級

- 如何成為郵儲食堂會員

- lol賽納技能介紹

- 夢幻誅仙如何學習升級煉藥

- 狂野飆車9特技怎么做

- 夢幻誅仙如何獲取特殊外觀的羽翼

- 無主之地3 主線 鷹身女妖之巢 任務攻略

- 歡樂斗地主殘局第43關(困難難度)攻略

- 公主連結如何提升英雄等級

- 夢誅小鎮如何生產麥芽糖

- 深海擱淺、strandeddeep、荒島求生迷路了怎么辦

- 香腸派對里面的近戰武器怎么拿出來

- 修業點怎么賣給別人

- 公主連結如何新建小號

- 閃耀暖暖印象怎么獲得